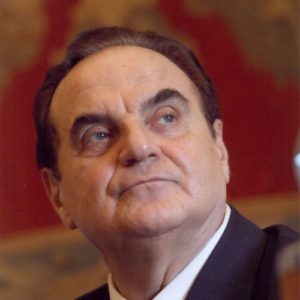

Par Giancarlo Elia Valori

Ces dernières années, le développement rapide des méthodes d’imagerie à haute dimension et haute définition a ouvert de vastes perspectives à ce secteur.

Des contenus visuels multidimensionnels et interactifs ont émergé dans un flux infini. La technique de prise de vue à 360° bullet time, introduite par le film Matrix (1999), a été largement utilisée dans les événements sportifs, les expositions d’arts performatifs et d’autres secteurs.

Le bullet time (projectile au ralenti) est un effet dans lequel un moment d’une scène est montré au ralenti, donnant l’impression que le regard de l’observateur se détache dans le temps et l’espace du sujet filmé ; ou mieux, si un protagoniste très rapide (dans le cas de la science-fiction) doit accomplir de nombreuses actions pendant le temps où une balle se dirige de l’arme à feu vers la cible, on ralentit la trajectoire de la balle et le protagoniste à vitesse normale accomplit ses actions.

L’infographie et l’industrie cinématographique interagissent profondément et obtiennent des résultats surprenants grâce à des recherches basées sur la science et l’intuition des réalisateurs et des programmeurs d’intelligence artificielle.

Il existe également un système de pré production virtuelle qui applique efficacement la technologie numérique tridimensionnelle en temps réel afin de réaliser des plans de création et des images sous forme de performances réelles + synthèse numérique.

Ce système a été utilisé dans la préproduction virtuelle de nombreux films tels que The Bravest (2019) et A city called Macau (2019). Des technologies connexes ont également été appliquées à des scénarios tels que des spectacles théâtraux et des événements sportifs, permettant une gestion intelligente de la conception du site, de la simulation du parcours et de la position de la caméra, ainsi que de la simulation de l’angle de vue des sièges du public.

Il est essentiel de soutenir le concept d’intégration profonde entre l’informatique et l’art, au même titre que l’innovation constante dans le processus de production cinématographique et télévisuelle, afin de rendre la création plus efficace et plus intelligente.

Pour résoudre le problème de la planification de la trajectoire de la caméra, indispensable dans le système de pré production virtuelle, a) un algorithme de contrôle de la caméra virtuelle basé sur des échantillons et des images clés a été développé, et b) une méthode plus intuitive et plus facile à utiliser pour générer automatiquement les trajectoires de la caméra a été proposée.

Grâce à l’apprentissage des techniques de mouvement de caméra à partir de films réels, il est possible de contrôler intelligemment le mouvement des caméras virtuelles afin d’obtenir des prises de vue de type cinématographique. La mise en œuvre de cette technologie apporte un soutien important au système de production virtuelle. Non seulement elle permet un contrôle flexible et efficace de la caméra, mais elle abaisse également le seuil d’utilisation du système de production virtuelle et permet de modifier la trajectoire de la caméra en temps réel.

Avec le développement rapide des modèles linguistiques à grande échelle, l’attention se porte sur les mouvements de caméra pour la génération de texte. D’une part, cela repose sur des capacités avancées de codage de texte pour comprendre les descriptions professionnelles de films et de programmes télévisés ; d’autre part, une correspondance entre le texte et les mouvements de caméra est établie à l’aide d’un modèle de diffusion.

Des recherches connexes permettent de générer automatiquement des plans spécifiques pour les mouvements de caméra à partir d’instructions textuelles, telles que pousser, tirer, secouer et déplacer l’objectif, changer de scène, ajuster les angles de prise de vue, etc., présentant ainsi une image visuelle conforme au contexte du scénario.

Il est possible de reconstruire numériquement des objets et des scènes dans le monde tridimensionnel afin d’obtenir des aspects similaires au monde réel. La recherche a permis d’obtenir un balayage et une reconstruction efficaces de la scène grâce à la collaboration entre plusieurs robots, améliorant ainsi encore l’efficacité du balayage de la scène et permettant une reconstruction numérique tridimensionnelle rapide du monde réel. La planification du parcours, la division du travail et la collaboration de plusieurs robots ont considérablement amélioré la vitesse de reconstruction et ont efficacement amélioré l’efficacité de l’acquisition et de la reconstruction des ressources numériques.

Les équipes de programmation exploitent l’intersection entre la physique et l’informatique pour simuler dans le monde numérique divers phénomènes naturels du monde réel et créer des animations avec des effets spéciaux raffinés et réalistes. On entre dans le domaine de la “simulation physique”, en cherchant à construire des scènes dynamiques plus précises et plus efficaces, au point que le spectateur se demande comment des scénarios similaires – en particulier catastrophiques – peuvent être représentés dans un environnement normal, c’est-à-dire ce que l’observateur considère comme un studio de cinéma ou un environnement naturel normal.

Ces dernières années, les équipes de programmation ont étudié de manière systématique l’utilisation de la technologie de capture de mouvement pour collecter des données sur les gestes humains et ont utilisé des méthodes d’apprentissage profond et de guidage multimodal telles que la voix et le texte pour obtenir la génération et le contrôle du mouvement, obtenant ainsi des effets tels que des gestes stylisés de personnages animés.

Au cours de l’année 2022, lors des XXIVes Jeux Olympiques d’hiver (4-20 février) et des XIIIes Jeux Paralympiques d’hiver (4-13 mars), la technologie et le système d’expérience visuelle multidimensionnelle interactive pour les événements sur glace et sur neige ont permis d’obtenir l’effet « Multi-Point of View » (Multi-POV) des retransmissions télévisées et cinématographiques, grâce à des prises de vue simultanées avec plusieurs séries de caméras, permettant à chaque spectateur, via son support multimédia, de contrôler indépendamment l’angle de vue et de regarder les moments passionnants des compétitions de manière plus immersive.

Transposé au cinéma, le Multi-POV fait référence à une technique narrative qui utilise différentes perspectives pour raconter une histoire, plutôt que de se concentrer sur un seul point de vue du personnage ou de l’intrigue : au lieu de voir l’histoire uniquement à travers les yeux d’un personnage, le Multi-POV permet au spectateur d’observer les événements et les relations entre les personnages sous différents angles, offrant ainsi une compréhension plus large et plus complète de l’histoire.

L’équipe a également introduit le « bullet time » dans la diffusion de l’événement, obtenant ainsi en direct un effet qui nécessitait à l’origine un long processus de calcul et de rendu. Ces technologies et les résultats de la recherche et du développement ont précisément vu le jour dans l’industrie cinématographique ; ils ont été appliqués à d’autres secteurs et contribueront au développement de la technologie de production cinématographique. Ils devraient apporter des changements significatifs dans le processus de création des « films » et favoriser le développement de supports d’imagerie multidimensionnels.

Giancarlo Elia Valori – Honorable de l’Académie des Sciences de l’Institut de France, Professeur honoraire à l’Université de Pékin.

(Les opinions exprimées dans cet article sont celles de l’auteur et ne reflètent pas nécessairement celles de World Geostrategic Insights).

Image: Le plateau d’un film réalisé par Kristyna Archer à l’aide d’une IA générative dans le cadre d’une production virtuelle.