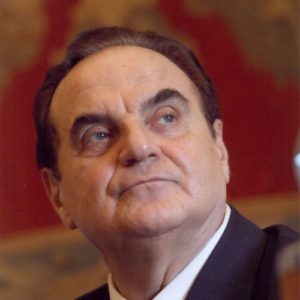

Por Giancarlo Elia Valori

MIT Technology Review, fundada por el Instituto Tecnológico de Massachusetts (MIT) en 1899, es una revista dedicada a difundir información sobre tecnologías emergentes y sectores innovadores. La sección «What’s Next?» de la revista se centra en las tendencias tecnológicas y, en lo que respecta a la inteligencia artificial, ha resumido los avances que tuvieron lugar en 2024 en cuatro temas principales.

Los grandes modelos lingüísticos siguieron dominando, los reguladores se volvieron más audaces y el problema apocalíptico de la inteligencia artificial tuvo un gran impacto en las instituciones de investigación y en el público.

En 2024, las empresas tecnológicas que invirtieron fuertemente en inteligencia artificial generativa lucharon por obtener beneficios de sus productos.

Para lograrlo, gigantes de la IA como Google y Open AI se han centrado en gran medida en la miniaturización: ambas empresas han desarrollado plataformas fáciles de usar que permiten a los usuarios personalizar potentes modelos lingüísticos y crear sus propios mini chatbots para satisfacer necesidades específicas.

En la práctica, cualquiera puede convertirse en desarrollador de aplicaciones de IA generativa, sin necesidad de tener conocimientos de programación.

El año pasado, la IA generativa se hizo más accesible para las personas sin conocimientos técnicos avanzados, principalmente porque tanto Google Gemini —que superó a GPT-4 en las pruebas de referencia (pruebas diseñadas específicamente para evaluar el rendimiento de un dispositivo o la eficacia de un proceso técnico) de texto, imágenes, vídeo y audio— como el propio GPT-4 —que admite la multifuncionalidad y puede procesar información de texto e imágenes, lo que abre una gama de nuevas aplicaciones— Veremos a personas de todos los ámbitos de la vida con su propio robot de IA personalizado. Los seres humanos solo tendrán que hacer clic en un botón y el sistema generará texto y subirá vídeos y fotos de acuerdo con las normas del sector.

Desde finales de 2022, hemos visto que Dall-E de OpenAI y Stable Diffusion de Stability AI pueden producir una variedad de imágenes extraordinarias. Por lo tanto, inevitablemente, en 2024, la atención se ha desplazado hacia las películas, tanto de los grandes estudios cinematográficos como de los usuarios individuales.

Runway es una startup que crea modelos de vídeo generativos (y cofundó Stable Diffusion). Ya es capaz de producir cortometrajes de alta calidad, los mejores de los cuales no están muy lejos de lo que podría haber logrado Pixar.

Además de startups como Runway, gigantes del cine como Paramount y Disney están explorando actualmente el uso de la IA generativa en el proceso de producción. La IA generativa está reinventando lo que antes era posible con los efectos especiales, que, en comparación con hoy en día, se conseguían haciendo todo lo posible.

Más allá de la gran pantalla, la tecnología deepfake también está ganando terreno con fines de marketing y formación. Por ejemplo, la empresa británica Synthesia crea herramientas que pueden transformar las actuaciones individuales de los actores en un flujo constante de avatares deepfake capaces de interpretar cualquier guión que se les proporcione con solo pulsar un botón.

Synthesia afirma que su tecnología es utilizada actualmente por el 44 % de las empresas de la lista Fortune 100 (es decir, las 100 mejores empresas para trabajar según la revista Fortune, que cubre la economía mundial y es publicada por Time Inc.s Fortune, fundada por Henry Luce en 1930; compite con Forbes y Bloomberg Businessweek en la categoría de revistas de negocios de EE. UU. y es conocida por sus artículos largos y en profundidad).

El uso de tanta experiencia a un coste tan bajo ha causado graves problemas a la industria del entretenimiento. La preocupación por el uso y abuso de la inteligencia artificial por parte de los estudios cinematográficos fue uno de los motivos principales de la huelga de Hollywood del año pasado. «El arte del cine está cambiando radicalmente», afirmó el cineasta independiente Souki Mehdaoui.

Cabe señalar también que la desinformación electoral generada por la IA será omnipresente. 2024 fue un año electoral en muchos países del mundo, y la desinformación electoral generada por la IA y los deepfakes se convirtieron en un problema importante. Hasta ahora, hemos visto a políticos de todo el espectro político utilizar estas herramientas como armas electorales, por ejemplo en Argentina, Eslovaquia y Estados Unidos.

La proliferación de estas obras generadas por IA es una tendencia preocupante. Será más difícil que nunca identificar el contenido auténtico en Internet. Y luchar en un clima político ya polarizado podría tener graves consecuencias.

Hasta hace unos años, se necesitaba tecnología avanzada para crear deepfakes, pero la inteligencia artificial generativa lo ha facilitado mucho y los productos finales parecen cada vez más reales. Incluso fuentes fiables pueden ser engañadas por la inteligencia artificial. Por ejemplo, las plataformas de fotos de archivo están inundadas de imágenes generadas por IA para cualquier evento.

Las fotos de archivo son imágenes que se pueden descargar de sitios web especializados, ya sea de forma gratuita o de pago, y que se pueden utilizar en proyectos creativos, gráficos y de comunicación. Actualmente están muy extendidas en el mundo digital, aunque las opiniones sobre su uso están divididas. Y en lo que respecta a las fotos de archivo, 2024 fue un año importante para quienes se oponen al uso de la inteligencia artificial en las elecciones.

Sin embargo, las tecnologías de seguimiento y resolución aún se encuentran en una fase inicial de desarrollo, como las marcas de agua. Para ser más precisos, si se desea marcar las fotos con el nombre u otra marca identificativa, o superponer imágenes y falsificarlas, se puede añadir una marca de agua. También es posible eliminar una marca de agua o utilizar una foto como marca de agua.

Las plataformas de redes sociales también son conocidas por su lentitud a la hora de erradicar la desinformación. En otras palabras, 2024 fue un año en el que todo el mundo, tanto los que estaban a favor como en contra desde el punto de vista moral, y los que estaban a favor y en contra desde el punto de vista económico, formaron parte de un gran experimento para combatir las noticias falsas basadas en la IA.

En los últimos años, el campo de la inteligencia artificial ha dejado de utilizar modelos más pequeños para adoptar un único modelo monolítico que puede entrenarse para realizar todas las tareas. Por ejemplo, mostrando a los mencionados OpenAI y GPT-3 algunos ejemplos adicionales, las partes interesadas pueden «entrenarlos» para resolver problemas de programación, escribir guiones de películas, aprobar un examen de biología de secundaria y mucho más. Los modelos multimodales, como GPT-4, Google Gemini y DeepMind, pueden resolver tareas tanto visuales como lingüísticas.

El mismo enfoque podría aplicarse a los robots físicos, por lo que ya no sería necesario entrenar a un robot para voltear tortitas y a otro para abrir puertas: un modelo universal podría dotar a los robots de la capacidad de realizar múltiples tareas.

Desde 2023, DeepMind ha lanzado Robocat, que ha aprendido a controlar diferentes brazos robóticos generando sus propios datos mediante ensayo y error. En octubre de 2023, DeepMind colaboró con treinta y tres laboratorios universitarios para lanzar otro modelo de robot polivalente, RT-X. Un equipo de la Universidad de Nueva York también está desarrollando una tecnología similar.

En los últimos años, las grandes empresas han comenzado a publicar grandes conjuntos de datos para el entrenamiento de robots, como Egocentric 4D Perception de Meta. EGO4D es un conjunto de datos egocéntricos a gran escala con una diversidad sin precedentes. Consta de 3670 horas de vídeo recopiladas de 923 participantes únicos de 74 lugares de 9 países diferentes. El proyecto reúne a 88 investigadores en un consorcio internacional con el objetivo de aumentar drásticamente el alcance de los datos egocéntricos disponibles públicamente en un orden de magnitud, lo que lo hace más de 20 veces mayor que cualquier otro conjunto de datos en términos de horas de metraje. EGO4D pretende catalizar la próxima era de la investigación sobre la percepción visual en primera persona.

El conjunto de datos es muy diverso en cuanto a cobertura geográfica, escenarios, participantes y métodos de adquisición. Por ejemplo, una encuesta de la Oficina de Estadísticas Laborales de Estados Unidos analiza cómo pasan la mayor parte de su tiempo las personas. Los datos se recopilaron utilizando siete cámaras montadas en la cabeza disponibles en el mercado: GoPro, Vuzix Blade, Pupil Labs, ZShades, OR-DRO EP6, iVue Rincon 1080 y Weeview. Además del vídeo, algunas partes de EGO4D ofrecen otras modalidades de datos: escaneos 3D, audio, mirada, estéreo, múltiples cámaras portátiles sincronizadas y narrativas textuales.

Este enfoque ya ha demostrado ser prometedor en el caso de los coches autónomos. Startups como Wayve, Waabi y Ghost están liderando una nueva ola de inteligencia artificial para la conducción autónoma que utiliza un único modelo grande para controlar el vehículo en lugar de múltiples modelos más pequeños para tareas de conducción específicas. Esta tecnología permite a las pequeñas empresas seguir el ritmo de los gigantes. Durante el próximo año, esta tendencia se observará en los robots desplegados en diversas industrias.

Como ya hemos argumentado en nuestros artículos y libros, el desarrollo de la inteligencia artificial hará que los seres humanos no solo estén más en la cima de la cadena alimentaria, sino que también sean completamente inútiles.

Autor: Giancarlo Elia Valori – Miembro de la Academia de Ciencias del Instituto de Francia, profesor honorario de la Universidad de Pekín.

(Las opiniones expresadas en este artículo pertenecen únicamente al autor y no reflejan necesariamente las opiniones de World Geostrategic Insights).